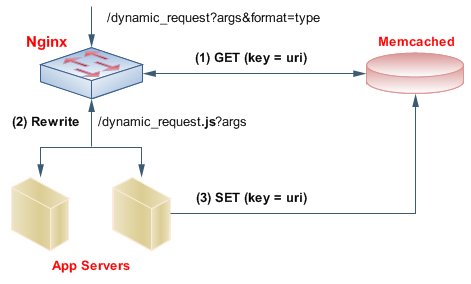

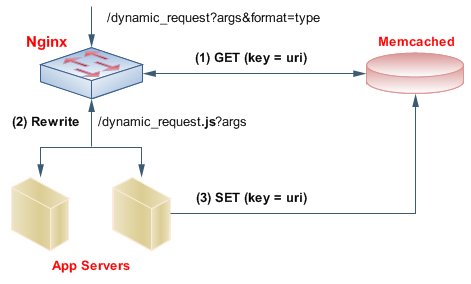

La configuration idéale serait proche de this:

En bref, nginx est un serveur web/avant-proxy rapide et léger avec un module unique qui nous allons il récupérer les données directement à partir memcached « s Mémoire RAM, sans toucher le disque, ou toute application web dynamique. Bien sûr, si l'URL de la requête n'était pas déjà mise en cache (ou si elle a expiré), la requête continue comme d'habitude vers la webapp. La partie géniale est que lorsque la webapp a généré la réponse, une copie de celle-ci va à memcached, prête à être réutilisée.

Tout cela est parfaitement applicable non seulement aux pages Web, mais aussi aux requêtes/réponses AJAX. Dans l'article, les serveurs «arrière» sont http, et parlent spécifiquement de mongrel. Ce serait encore mieux si le dos était FastCGI et autre (plus rapide?) Cadre; mais c'est beaucoup moins critique, puisque l'équipe nginx/memcached absorbe la plus grande partie de la charge.

Notez que si votre schéma d'URL pour le trafic AJAX est bien conçu (REST est meilleur, IMHO), vous pouvez mettre la plupart des DB droit dans memcached, et tout POST (qui passera à l'application) peut mettre à jour préventivement le cache.

up a voté, merci, je pense que je vais aller avec python, postgresql – daniels